Deep Learning: inteligência artificial que imita o cérebro humano

É um passáro, é um avião? Tarefas relativamente simples, que fazemos sem pensar, como discernir um objeto entre um pássaro, um avião ou Superman, são, na realidade, bem complexas para um computador. Um computador enxerga uma fotografia, por exemplo, como uma matriz de números representando as cores e intensidades dos pixels. Por muito tempo, cientistas procuraram identificar objetos em imagens delineando contornos e depois extraindo atributos como forma ou distribuição de intensidades. Baseados nestes atributos buscavam então classificar os objetos. Para cada tipo de objeto, diversos algoritmos e hipóteses diferentes foram desenvolvidos e testados, num framework quase que artesanal. Todo esse processo tomou outra dimensão recentemente com o desenvolvimento de redes neurais que "aprendem" a realizar essas tarefas, num processo muito semelhante ao que ocorre dentro de nosso cérebros.

Estamos assistindo a momentos emocionantes da Inteligência Artificial (AI em inglês) nos últimos anos. Essa revolução foi trazida por arquiteturas de "Deep Learning", que quando treinadas numa base de dados aprendem a extrair características que lhe permitem reconhecer padrões. Assim, como nós mesmos fazemos no córtex visual de nossos cérebros, computadores agora podem começar a reconhecer um pássaro depois de "estudarem" vários exemplos, ao invés de utilizarem descrições detalhadas do que é um pássaro. Rapidamente essas redes se tornaram o estado da arte para resolver diversos problemas de classificação e aprendizado de máquina. Foi um grande salto para desafios como reconhecimento de voz, processamento de linguagem natural, visão computacional e bioinformática.

Estive em 2015 numa conferência sobre Visão Computacional e Reconhecimento de Padrões em Boston, e a palestra mais aguardada era a do francês Yann LeCun, então diretor de AI do Facebook. Alguns anos antes, em 2012, LeCun teve um artigo que contribuía para o desenvolvimento dessas redes neurais rejeitado por essa mesma conferência. Os revisores não haviam entendido a contribuição de seu trabalho, que não usava o framework tradicional de decomposição de imagens. Poucos anos depois, esse mesmo método já havia transformado a Visão Computacional e já era aplicado por grande parte da comunidade científica. LeCun teve então sua volta triunfal ao prestigioso evento, falando em posição de destaque do que era agora o tema da conferência.

Em seu trabalho após o doutorado, LeCun desenvolveu métodos e algoritmos para redes neurais desenvolvidas para reconhecer letras de mão (esse algoritmo foi rapidamente adotado por bancos para lerem cheques e pelo correio americano para reconhecer os endereços em cartas). Esse trabalho resultou na publicação em 1998 do artigo que deu origem às redes convolucionais. Essas redes são estruturadas em várias camadas sucessivas de processamento que "filtram" a informação relevante a cada passo, para que partindo de informações básicas como bordas e formas de uma imagem, ao fim se possa extrair conceitos complexos como um "pássaro". LeCun, seu mentor Geoffrey Hinton e seu colega Yoshua Bengio são hoje considerados os pais do Deep Learning, mas essa técnica demorou para ser reconhecida, e ficou fora do radar dos especialistas da área por muito tempo.

Mesmo com os avanços dos modelos e algoritmos propostos pelas redes convolucionais, faltava uma parte muito importante: dados, muitos dados. Deep learning é um modelo que precisa ser "alimentado" com dados contendo várias representações de um objeto para que a rede seja treinada de forma robusta. Reconhecendo o potencial desse método, o grupo de Fei-Fei Li em Stanford, compôs uma grande base de imagens para o treinamento de redes neurais, o ImageNet. Essa base tem milhares de imagens de objetos como carros, árvores e gatos, junto com as descrições (ou rótulos) de cada uma delas para servir de referência. Li então lançou em 2010 um desafio anual no qual equipes de pesquisadores tentavam desenvolver os algoritmos mais precisos para diversas tarefas de reconhecimento visual. Em 2012 Hinton e LeCun finalmente entraram nesse desafio com suas novas redes convolucionais, e causaram frisson com uma performance bem acima de todos os outros participantes. Esse resultado espetacular foi o ponto de virada para as redes convolucionais. No mesmo ano em que tiveram seu artigo rejeitado, os resultados deste desafio deixaram óbvias as vantagens deste modelo de deep learning, e finalmente tudo mudou.

Rapidamente começou a corrida por algoritmos de Inteligência Artificial nas grandes companhias de tecnologia. A ferramenta de tradução do Google deu um salto de qualidade ao usar AI ao invés de regras gramaticais. Em Londres, a DeepMind (adquirida pelo Google) desenvolveu AlphaGo, um software que aprende o jogo de Go treinando contra si mesmo, que foi o primeiro a ganhar de um campeão mundial. O Facebook desenvolveu a busca de pessoas e lugares nas fotografias.

Se você tem curiosidade de ver e interagir com uma rede de machine learning, entre neste site do Google. O tutorial explica como treinar a rede neural com a câmera do seu computador, obtendo respostas divertidas. A ideia básica é simples: suas imagens enquanto realiza diferentes movimentos são usadas para treinar o computador, que passa a reconhecer os padrões nas imagens. Assim, quando você repete esse movimento no futuro o computador pode usar o modelo aprendido para identificá-lo.

A revolução por AI já está mudando as ferramentas oferecidas pelas grandes empresas de tecnologia, e muitos produtos serão lançados em breve. Alguma aplicações bacanas que estão sendo desenvolvidas usam plataformas em robôs, smartphones, drones e satélites. Falaremos mais sobre isso em próximos posts, fique ligado!

Sobre os autores

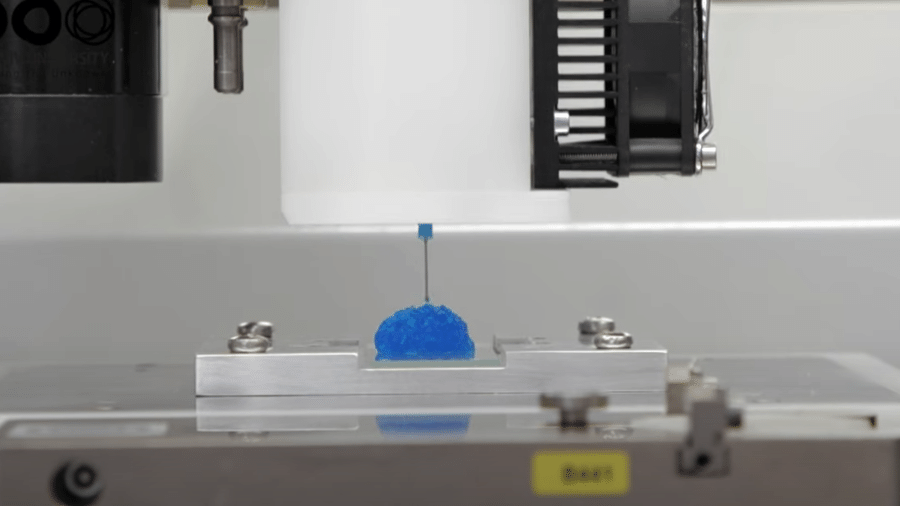

Monica Matsumoto é cientista e professora de Engenharia Biomédica no ITA. Curiosa, ela tem interesse em áreas multidisciplinares e procura conectar pesquisadores em diferentes campos do conhecimento. Monica é formada em engenharia pelo ITA e doutora em ciências pela USP, e trabalhou em diferentes instituições como InCor/HCFMUSP, UPenn e EyeNetra.

Shridhar Jayanthi é Agente de Patentes com registro no escritório de patentes norte-americano (USPTO) e tem doutorado em Engenharia Elétrica pela Universidade de Michigan (EUA) e diploma de Engenheiro de Computação pelo ITA. Atualmente, ele trabalha com empresas de alta tecnologia para facilitar obtenção de patentes e, nas (poucas) horas vagas, é um estudante de problemas na intersecção entre direito, tecnologia e sociedade. Antes disso, Shridhar teve uma vida acadêmica com passagens pela Rice, MIT, Michigan, Pennsylvania e no InCor/USP, e trabalhou com pesquisa em áreas diversas da matemática, computação e biologia sintética.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.